Qualidade de Dados na Prática

Garantindo a Qualidade dos seus Dados Com Ferramentas Modernas na AWS

Você vai aprender:

Governança e Qualidade de Dados na Prática

Great Expectations, dbt Tests, Soda e Glue Data Quality

Contratos de Dados e Open Metadata

Observabilidade de Dados e Alertas Pro-Ativos

Se você quer aprender como garantir a qualidade dos seus dados com ferramentas modernas, este treinamento é para você.

Será uma imersão prática, com muita interação e exemplos reais, onde você aprenderá a detectar, monitorar e garantir a confiabilidade dos dados em seus pipelines.

☁️ Todo o treinamento será utilizando a AWS

✅ Slides, Código Fonte e Certificado de Participação

🎥 Ao vivo e gravado!

Dia 08 de Novembro 2025

Das 9h às 18h

Módulo 1

Conceitos sobre Governança e Qualidade de Dados

Módulo 2

Qualidade de Dados com dbt Tests e Airflow

Módulo 3

Qualidade de Dados com Great Expectations com Airflow ou Spark

Módulo 4

Módulo 5

Módulo 7

Qualidade de Dados com Soda + Airflow e Soda + Spark

Qualidade de Dados com Glue Data Quality e Spark

Especificações de Contratos de Dados e Validações Automáticas

Módulos do Treinamento:

Módulo 6

Observabilidade de Dados com Grafana

Módulo 8

Qualidade e Observabilidade de Dados com Open Metadata

Módulo 9

Melhoria contínua e estrategias para aplicar e escalar a Qualidade

O que você vai aprender na Prática

Qualidade de Dados

Fundamentos de Qualidade de Dados e sua importância

Como estruturar testes e validações automáticas nos pipelines

Implementação prática com Soda, dbt Tests, Glue Data Quality e Open Metadata

Testes e Validações

Frameworks

Observabilidade de Dados

Estratégias para monitoramento contínuo e alertas proativos

Governança de Dados

Melhoria Contínua

Melhores práticas para escalar a qualidade dos dados em projetos reais

Fundamentos de Governança de Dados e como aplicar na prática

Investimento de

R$ 277,00

R$ 127,00

🎓 Nível e Pré-requisitos

Nível: Intermediário

Pré-requisitos:

✔ Conhecimento Básico de SQL

✔ Familiaridade com pipelines de dados (Spark)

✔ Conhecimento básico em AWS

🎯 Por que participar?

Se você trabalha com dados e quer aprender como melhorar a confiabilidade e governança dos seus pipelines, esse treinamento é essencial. Você verá na prática como implementar testes, monitorar qualidade e garantir que seus dados sejam sempre confiáveis.

👤 Para quem é?

Engenheiros e Analistas de Dados que querem integrar Qualidade de Dados em suas Pipelines

Profissionais de tecnologia que desejam aprender arquiteturas modernas na AWS.

Quem quer sair do conceito e colocar Qualidade de Dados em produção de verdade.

Sobre o seu Instrutor

Cicero Moura é Arquiteto de Dados com mais de 10 anos de experiência em tecnologia da informação, atuando em projetos de alto impacto para empresas líderes no Brasil.

Especialista em Big Data, Engenharia de Dados e Arquiteturas na AWS.

Tem forte atuação na comunidade tech.

É AWS Community Builder há 5 anos consecutivos e líder do AWS User Group Goiânia.

Criador do projeto Data HandsON, já impactou mais de 200 alunos com formações práticas em dados e cloud.

Redes Sociais:

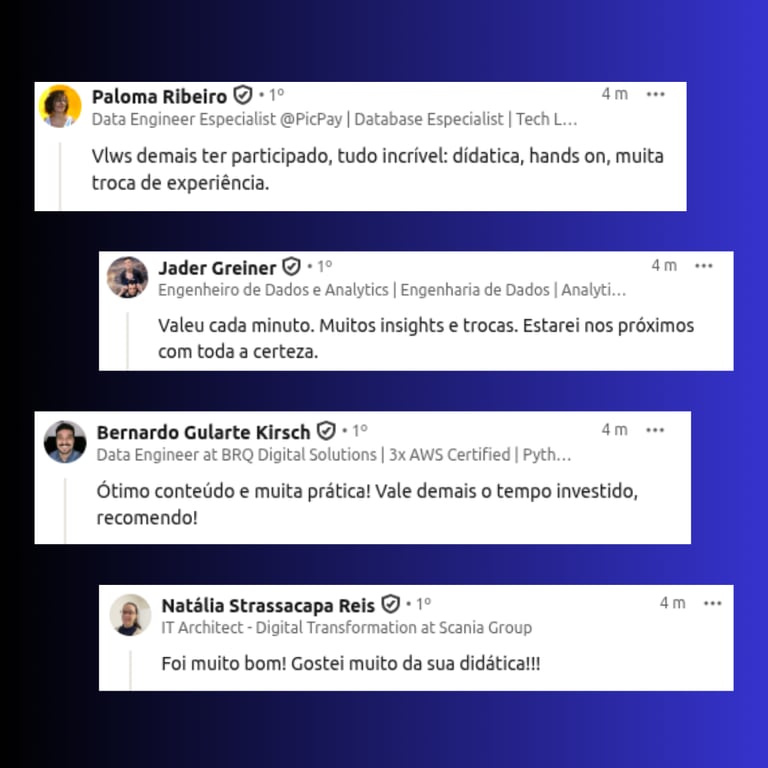

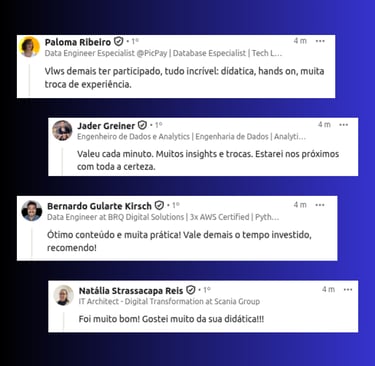

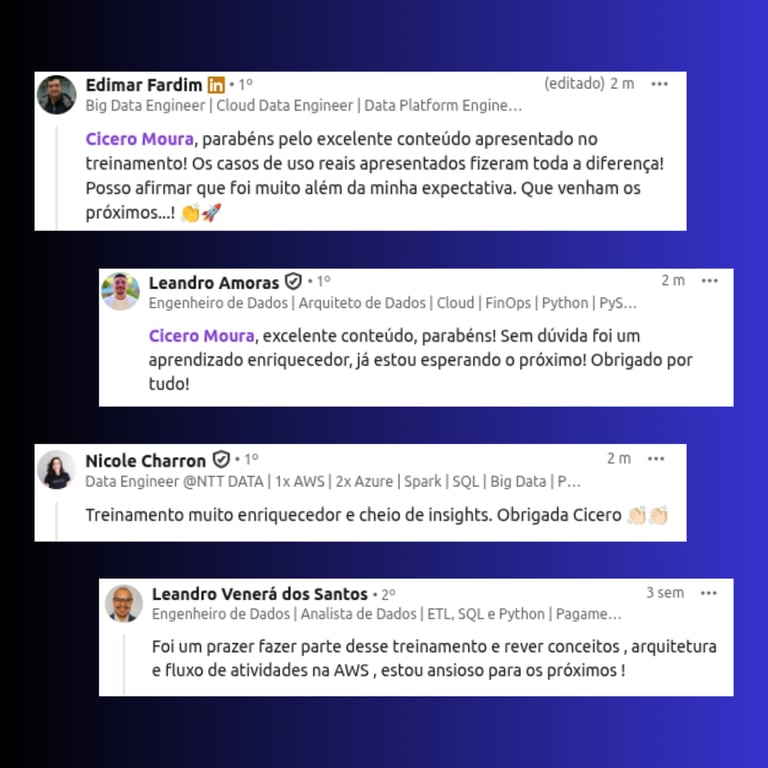

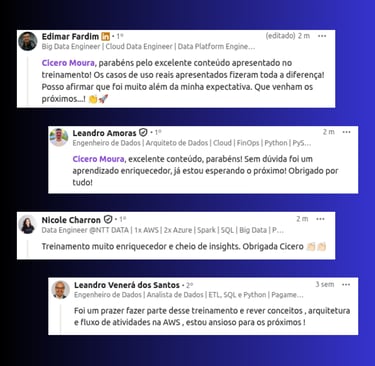

★★★★★

Depoimentos dos Alunos

Perguntas Frequentes

Para quem é este workshop?

Este workshop é ideal para Analistas, Engenheiros, Arquitetos e Cientistas de Dados que tenham interesses em Garantir a Qualidade dos seus Dados.

Preciso ter experiência com AWS para participar?

É importante que você tenha alguma vivência, mesmo que básica no ambiente da AWS e conceitos de pipelines em Spark ou Python.

O conteúdo é ao vivo ou gravado?

As aulas são ao vivo e interativas, permitindo tirar dúvidas em tempo real. Mas também disponibilizamos as gravações para você assistir depois.

Vou receber certificado de participação?

Sim! Todos os participantes que concluírem o workshop recebem um certificado digital comprovando sua participação.

Terei acesso ao conteúdo após o workshop?

Sim! Você terá acesso às gravações, materiais complementares e repositórios usados no workshop por tempo ilimitado.

Quais ferramentas serão usadas para construir a aplicação?

Serão usadas diversas ferramentas: Redshift, Airflow, Open Metadata, dbt, Great Expectations, Soda, Glue, Grafana e Mais!