Engenharia de Dados na Prática

Construindo um Lakehouse de ponta a ponta na AWS

Você vai aprender:

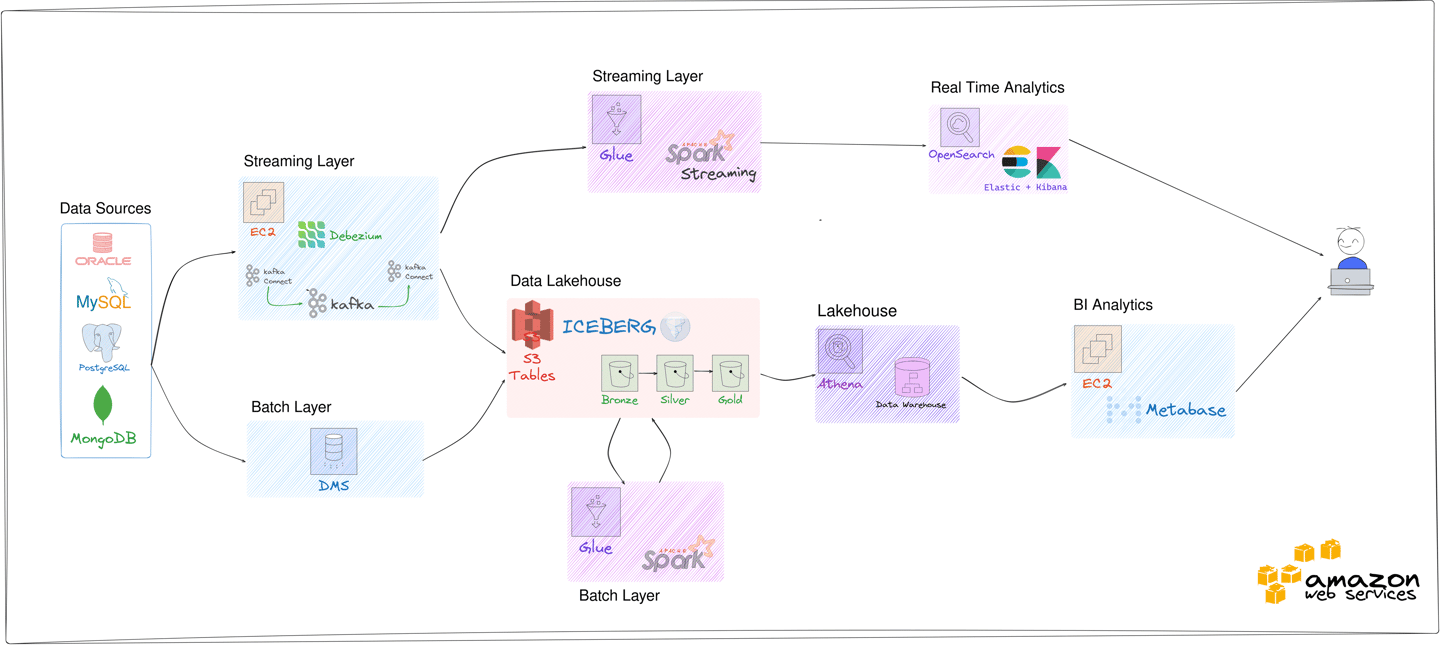

Montar do zero um pipeline moderno com ingestão batch e streaming

Processar e modelar dados com Spark e Iceberg

Deploy de toda a arquitetura em cloud com AWS

Criar a infraestrutura como código através do Terraform

Prepare-se para uma imersão prática de 8 horas no universo da Engenharia de Dados moderna!

Neste workshop intensivo e direto ao ponto, você vai aprender como construir um pipeline completo de dados — da ingestão à visualização — usando tecnologias modernas, cloud-native e open-source.

Para quem é este workshop?

✅ Engenheiros de Dados que querem aplicar conceitos modernos como Lakehouse e CDC

✅ Analistas de Dados que desejam evoluir para o universo da engenharia

✅ Cientistas de Dados que precisam montar pipelines robustos e escaláveis

✅ Profissionais de BI que desejam automatizar ingestão e processamento de dados

✅ Estudantes e iniciantes que querem aprender com um projeto prático e guiado

☁️ Todo o treinamento será utilizando a AWS

🎥 Ao vivo e gravado!

06 de Setembro 2025

Das 9h às 18h

Vagas Limitadas!

O que você vai aprender

Ingestão por Batch

Extração e ingestão de dados por Batch utilizando o DMS

Armazenando e modelagem dos dados com Iceberg no S3 Tables

Processamento de dados com Spark no Glue ETL

S3 Tables

Processamento de Dados

Visualização de Dados

Construção de visualização de dashboards utilizando Metabase

Streaming de Dados

Deploy em Produção

Deploy completo da aplicação na AWS com IaC através do Terraform

Extração e ingestão por Streaming utilizando Debezium e Kafka

Investimento de

R$ 127,00

🎓 Nível e Pré-requisitos

🧠 Nível: Básico ao Intermediário

🧩 Pré-requisitos:

✔ Familiaridade com conceitos de Engenharia de Dados

✔ Conhecimento básico em Cloud

✔ Noções de ETL com Spark ou outras ferramentas de dados

🎯 Por que participar?

A Engenharia de Dados moderna é a base das decisões data-driven em empresas de todos os setores.

Neste workshop, você vai construir na prática uma arquitetura completa de dados na AWS, integrando extração batch e streaming, processamento com Spark, armazenamento em Lakehouse com Iceberg, e visualização de dados quase em tempo real.

Tudo isso em apenas 8 horas, com um projeto real e orientado por casos de uso do mercado.

Sobre o seu Instrutor

Cicero Moura é Arquiteto de Dados com mais de 10 anos de experiência em tecnologia da informação, atuando em projetos de alto impacto para empresas líderes no Brasil.

Especialista em Big Data, Engenharia de Dados e Arquiteturas na AWS.

Tem forte atuação na comunidade tech.

É AWS Community Builder há 5 anos consecutivos e líder do AWS User Group Goiânia.

Criador do projeto Data HandsON, já impactou mais de 200 alunos com formações práticas em dados e cloud.

Redes Sociais:

Módulos do Treinamento

Durante 8 horas de prática guiada, você vai aprender

3. Extração Streaming com Debezium

1. Fundamentos e Extração de Dados

Aprenda os conceitos por trás de uma arquitetura moderna de dados.

Entenda a diferença entre batch e streaming e quando usar cada abordagem.

2. Extração Batch com DMS

4. Armazenamento de dados com S3 Tables

5. Criação de Dashboards com Metabase

6. Deploy da Infraestrutura com Terraform

Organize os dados em formatos otimizados e escaláveis usando tabelas no S3 com suporte ao Apache iceberg. Base para uma arquitetura Lakehouse com baixo custo e alta performance.

Implemente captura de dados em tempo real com Kafka e Debezium.

Monitore e replique alterações em bases transacionais de forma eficiente.

Conecte sua estrutura de dados ao Metabase e gere dashboards atualizados quase em tempo real.

Transforme dados brutos em insights visuais.

Automatize a ingestão de dados com o AWS DMS, extraindo informações de bancos relacionais.

Ideal para cargas iniciais e sincronizações periódicas.

Implemente toda a infraestrutura de dados com código reutilizável e versionado.

Garanta consistência e agilidade com Terraform.

Arquitetura a ser Desenvolvida no Workshop

Perguntas Frequentes

Quando será o workshop?

O workshop acontecerá no dia 06 de setembro, das 9h às 18h (horário de Brasília), com carga horária total de 8 horas.

Preciso ter experiência prévia em Engenharia de Dados?

Não é necessário ser especialista, mas é importante ter familiaridade com conceitos básicos de engenharia de dados, Cloud e ETL.

O conteúdo é ao vivo ou gravado?

As aulas são ao vivo e interativas, permitindo tirar dúvidas em tempo real. Mas também disponibilizamos as gravações para você assistir depois.

Vou receber certificado de participação?

Sim! Todos os participantes que concluírem o workshop recebem um certificado digital comprovando sua participação.

Terei acesso ao conteúdo após o workshop?

Sim! Você terá acesso às gravações, materiais complementares e repositórios usados no workshop por tempo ilimitado.

Quais ferramentas serão usadas para construir a aplicação?

Serão usadas diversas ferramentas open-source e serviços da AWS: DMS, StepFunctions, S3, Glue, Athena, Spark, Metabase e outros mais!